Hatte einen Raspberry 3 übrig und einen Inverter ans LAN zu bringen…und das bitte headless.

Mit Raspberry Pi Imager Raspberry Pi OS Lite (64-bit, Bookworm) MicroSD erzeugen – da kann man WLAN, SSH & Co. schön vorkonfigurieren.

Wenn das Ding dann am WLAN online ist über NetworkManager dieses auf eth0 sharen (nur IPv4)

sudo nmcli con add con-name share-wlan type ethernet ifname eth0 ipv4.method shared ipv6.method ignore

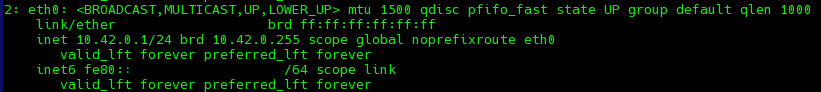

Das macht aus eth0 einen Router/DHCP/DNS Server (mit dnsmasq) mit der Adresse 10.42.0.1/24

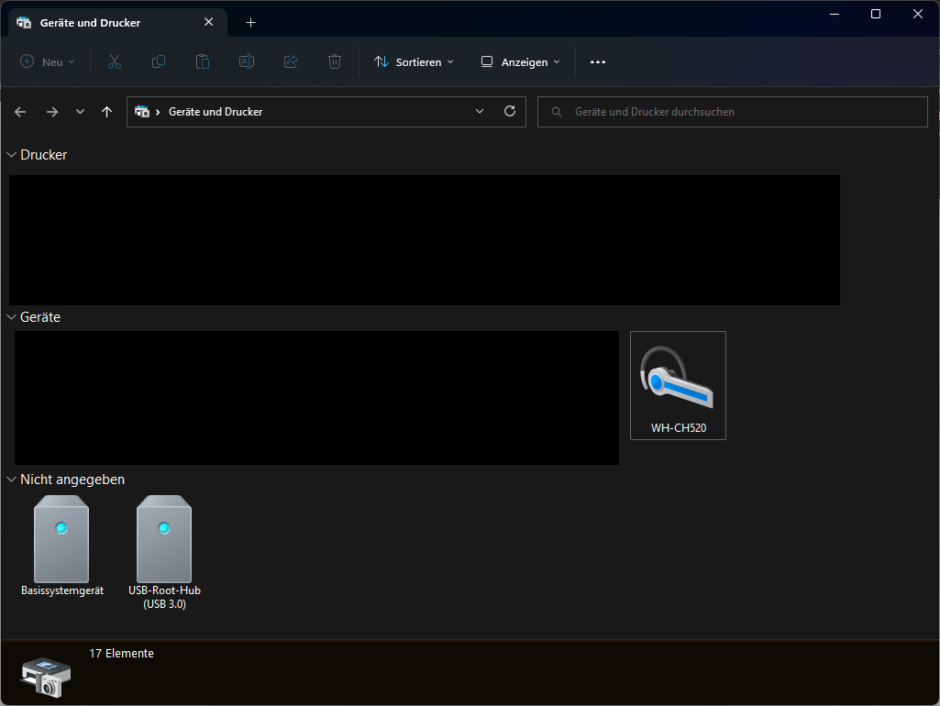

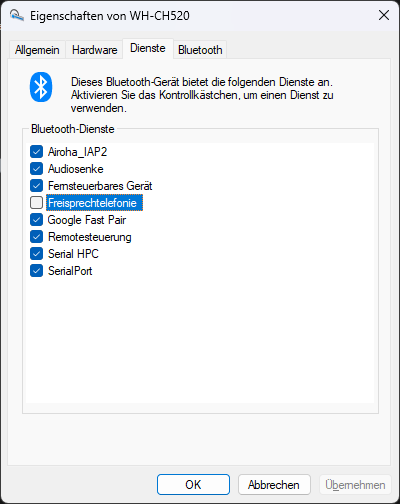

Was sich am LAN Interface so tut (wenn man MAC Adresse zwecks Fixierung wissen will)

sudo journalctl -u NetworkManager -fDHCP Leases findet man in

sudo cat /var/lib/NetworkManager/dnsmasq-eth0.leasesUnd statisch kann man sie dann hier definieren:

sudo micro /etc/NetworkManager/dnsmasq-shared.d/static-addresses

1 Host pro Zeile:

dhcp-host=mm:mm:mm:mm:mm:mm,10.42.0.xxxQuelle: https://fedoramagazine.org/internet-connection-sharing-networkmanager/